A inteligência artificial construída sobre um conjunto de informações potencialmente tendenciosas cria um risco real de automatizar a discriminação, mas existe uma maneira de retreinar as máquinas?

A questão para alguns é muito urgente. Nesta era do ChatGPT, a IA gerará cada vez mais decisões para prestadores de cuidados de saúde, credores bancários ou advogados, utilizando o que recolhem da Internet como fonte de informação.

Portanto, é provável que a inteligência subjacente de uma IA seja tão boa quanto o mundo em que ela se origina, repleta de inteligência, sabedoria e utilidade, bem como de ódio, preconceito e abuso.

“É perigoso porque as pessoas estão aceitando e adotando software de IA e realmente confiando nele”, disse Joshua Weaver, diretor da Texas Opportunity and Justice Incubator, uma consultoria jurídica.

“Podemos acabar num ciclo de feedback onde os nossos próprios preconceitos e preconceitos culturais influenciam os preconceitos da IA, criando uma espécie de ciclo de reforço”, disse ele.

Fazer com que a tecnologia reflita com mais precisão a diversidade humana não é apenas uma escolha política.

Outras utilizações da IA, como o reconhecimento facial, têm levado as empresas a entrar em conflito com as autoridades por causa da discriminação.

De acordo com a Comissão Federal de Comércio, este é um caso contra a Rite Aid, uma cadeia de farmácias dos EUA onde as câmaras das lojas identificaram falsamente os consumidores, especialmente mulheres e pessoas de cor, como ladrões de lojas.

– “Isso estava errado” –

Os especialistas temem que a IA generativa no estilo ChatGPT, que pode criar qualquer coisa que se assemelhe ao raciocínio de nível humano em apenas alguns segundos, apresente novas oportunidades para errar.

As grandes empresas de IA estão bem conscientes desta questão e estão preocupadas com a possibilidade de os seus modelos se comportarem mal ou refletirem demasiado a sociedade ocidental, dada a sua base global de utilizadores.

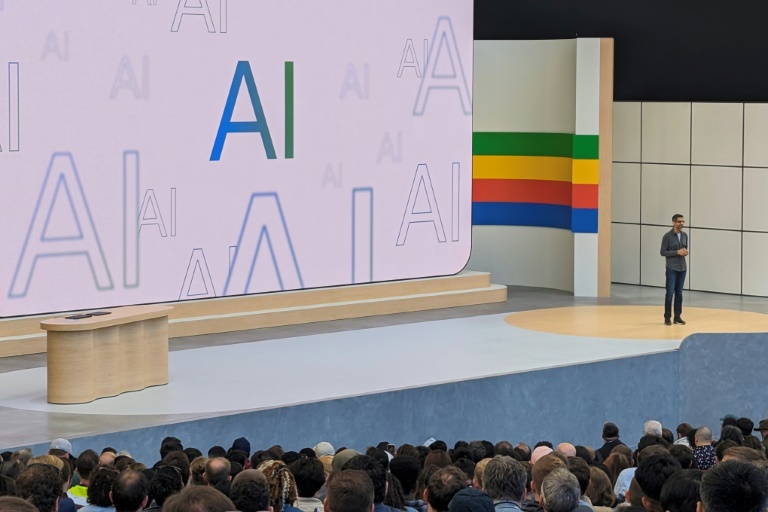

“Recebemos pessoas da Indonésia e dos Estados Unidos que nos contataram”, disse o CEO do Google, Sundar Pichai, explicando por que o Google se esforça para garantir que os pedidos de imagens de médicos e advogados reflitam a diversidade racial.

Mas estas considerações podem atingir níveis de irracionalidade e levar a acusações furiosas de correcção política que foram longe demais.

Foi o que aconteceu quando o gerador de imagens Gemini do Google cuspiu absurdamente imagens de soldados alemães da Segunda Guerra Mundial, que incluíam um homem negro e uma mulher asiática.

“O erro foi obviamente aplicá-lo onde não deveria. Isso foi um bug e estávamos errados”, disse Pichai.

Mas Sacha Luccioni, cientista pesquisador da Hugging Face, uma plataforma líder de modelagem de IA, disse: “Se você acha que existe uma solução técnica para o preconceito, você já está no caminho errado”, alertou.

A IA generativa trata essencialmente de saber se o resultado “corresponde às expectativas do usuário”, o que é amplamente subjetivo, disse ela.

O enorme modelo usado para construir o ChatGPT “não pode inferir o que é tendencioso e o que é imparcial, então não podemos fazer nada a respeito”, alerta Jayden Ziegler.

Pelo menos por enquanto, cabe aos humanos garantir que a IA produza as coisas certas e corresponda às suas expectativas.

– Viés “assado” –

Mas dado o entusiasmo em torno da IA, isso não é tarefa fácil.

Aproximadamente 600.000 modelos de IA ou aprendizado de máquina estão disponíveis na plataforma Hugging Face.

“A cada poucas semanas, novos modelos são lançados e estamos nos esforçando para avaliar e documentar preconceitos e comportamentos indesejáveis”, disse Luccioni.

Uma técnica em desenvolvimento é chamada de repartição algorítmica, que permite aos engenheiros remover conteúdo sem arruinar todo o modelo.

No entanto, existem sérias dúvidas se isso realmente funciona.

Ram Sriharsha, diretor de tecnologia da Pinecone, disse que um método alternativo é “encorajar” o modelo a se mover na direção certa, “ajustar” o modelo e “recompensar o que é bom e o que é ruim”.

A Pinecone é especialista em geração de aumento de pesquisa (RAG), uma tecnologia onde os modelos obtêm informações de fontes fixas e confiáveis.

Para Weaver, da Texas Opportunity and Justice Incubator, estas tentativas “nobres” de corrigir preconceitos são “uma projecção das nossas esperanças e sonhos sobre como poderia ser um futuro melhor”.

Mas o preconceito é “inerente ao que significa ser humano, por isso também está incorporado na IA”, disse ele.

juj-arp/md