O laboratório de pesquisa de IA do Google, Google DeepMind, publica novas pesquisas sobre modelos de IA de treinamento, acelerando significativamente a velocidade de treinamento e a eficiência energética em uma ordem de magnitude, proporcionando desempenho de 13x e melhoria de 10x em relação a outros métodos. A nova metodologia de treinamento JEST surge num momento em que há um debate crescente sobre o impacto ambiental dos data centers de IA.

O método da DeepMind, chamado JEST ou seleção colaborativa de amostras, separa-se dos métodos tradicionais de treinamento de modelos de IA de uma forma simples. Embora os métodos de treinamento comuns se concentrem em pontos de dados individuais para treinamento e aprendizado, o JEST treina em lotes inteiros. O método JEST começa construindo um pequeno modelo de IA que avalia a qualidade dos dados de fontes de altíssima qualidade e classifica os lotes por qualidade. Em seguida, compare essa classificação com um conjunto maior e de qualidade inferior. O modelo JEST menor determina o melhor lote para treinar e, em seguida, o modelo maior é treinado com base nos resultados do modelo menor.

O próprio artigo, disponível aqui, fornece uma explicação mais completa do processo utilizado no estudo e do futuro do estudo.

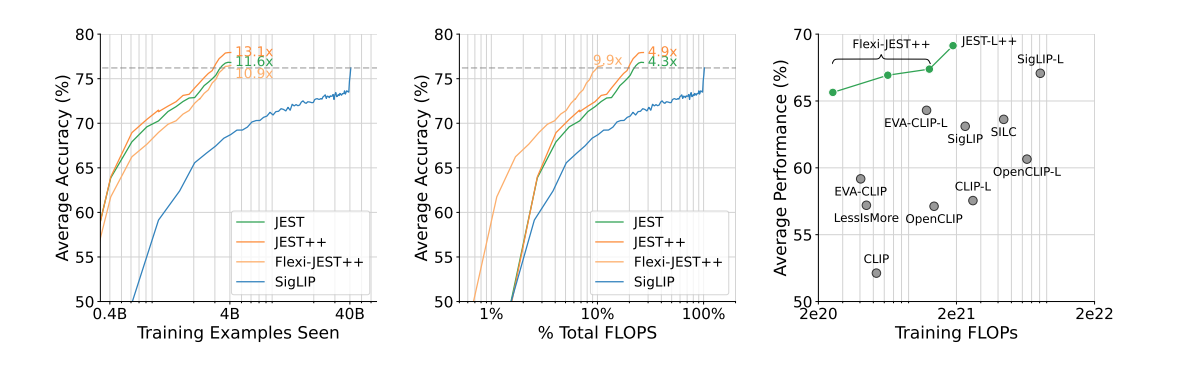

Em seu artigo, os pesquisadores da DeepMind deixam claro que esta “capacidade de orientar o processo de seleção de dados para a distribuição de conjuntos de dados pequenos e bem selecionados” é crítica para o sucesso da metodologia JEST. Sucesso é a palavra perfeita para esta pesquisa. DeepMind afirma que “nossa abordagem supera modelos de última geração com até 13x menos iterações e 10x menos esforço computacional”.

Obviamente, este sistema depende totalmente da qualidade dos dados de treinamento. Sem conjuntos de dados da mais alta qualidade e com curadoria humana, as técnicas de bootstrapping não funcionarão. O mantra “entra lixo, sai lixo” nunca é mais verdadeiro do que com este método, que tenta “pular adiante” no processo de treinamento. Isso torna o método JEST uma boa opção para amadores e desenvolvedores amadores de IA, já que a curadoria dos melhores dados de treinamento inicial provavelmente exigirá habilidades de pesquisa de nível especializado, muito mais difíceis do que a maioria dos métodos.

A investigação do JEST não pode acontecer em breve, à medida que a indústria tecnológica e os governos mundiais começam a discutir as extremas exigências de energia da inteligência artificial. As cargas de trabalho de IA representarão aproximadamente 4,3 GW em 2023, aproximadamente equivalente ao consumo anual de eletricidade do país de Chipre. E as coisas certamente não estão desacelerando. Uma única solicitação ChatGPT custa 10 vezes mais do que uma pesquisa no Google, e o CEO da Arm estima que a IA abastecerá um quarto da rede elétrica dos EUA até 2030.

Resta saber se e como o método JEST será adotado pelas principais empresas do setor de IA. O treinamento GPT-4o supostamente custa US$ 100 milhões, e futuros modelos maiores poderão em breve atingir a marca de US$ 1 bilhão, então como as empresas podem economizar suas carteiras nesta área Você pode estar procurando. Os Hopers acreditam que podem usar a metodologia JEST para manter a produtividade atual do treinamento com um consumo de energia muito menor, reduzir os custos de IA e ajudar o planeta. Mas é muito mais provável que as máquinas da Capital usem o método JEST para manter o pedal no metal, mantendo o consumo de energia no máximo para resultados de treinamento ultrarrápidos. O que ganha: redução de custos ou escala de produção?