O modelo subjacente é um modelo de aprendizagem profunda em grande escala pré-treinado em grandes quantidades de dados não rotulados de uso geral. Eles podem ser aplicados a diversas tarefas, como gerar imagens e responder perguntas de clientes.

No entanto, estes modelos servem como espinha dorsal de poderosas ferramentas de inteligência artificial, como ChatGPT e DALL-E, e podem fornecer informações falsas ou enganosas. Em situações críticas de segurança, como quando um pedestre se aproxima de um carro que dirige sozinho, esses erros podem ter consequências graves.

Para evitar tais erros, pesquisadores do MIT e do MIT-IBM Watson AI Lab desenvolveram um método para estimar a confiabilidade de um modelo subjacente antes de implementá-lo em uma tarefa específica.

Isso é feito treinando um conjunto de modelos básicos ligeiramente diferentes uns dos outros. Em seguida, usamos um algoritmo para avaliar a consistência das representações que cada modelo aprende sobre os mesmos pontos de dados de teste. Se a representação for consistente, significa que o modelo é confiável.

Comparamos seu método com métodos de linha de base de última geração e descobrimos que ele era melhor para capturar a confiabilidade do modelo subjacente em uma variedade de tarefas de classificação.

Essa técnica permite decidir se um modelo deve ser aplicado a uma configuração específica sem testá-lo em conjuntos de dados do mundo real. Isto é especialmente útil quando os conjuntos de dados estão inacessíveis devido a questões de privacidade, como em ambientes médicos. Além disso, esta técnica também pode ser usada para classificar modelos com base em suas pontuações de confiabilidade, permitindo aos usuários escolher o melhor modelo para sua tarefa.

“Todos os modelos podem estar errados, mas os modelos que sabem quando estão errados são mais úteis. Esses modelos subjacentes sofrem de incerteza e confiança porque suas representações abstratas são difíceis de comparar. O problema de quantificar a confiabilidade torna-se ainda mais difícil. Nosso método nos permite para quantificar a confiabilidade de um modelo de representação para um determinado conjunto de dados de entrada.'', disse Navid Azizan, professor assistente Esther e Harold E. Edgerton no Systems Research Institute. Associação de Sistemas de Informação e Decisão (IDSS), membro do Instituto de Sistemas de Informação e Decisão (LIDS).

Ele é acompanhado pelo autor principal, Young-Jin Park, um estudante de pós-graduação do LIDS, em um artigo sobre a pesquisa. Hao Wang, pesquisador do MIT-IBM Watson AI Lab. e Shervin Aldeshir, pesquisador sênior da Netflix. Este artigo será apresentado em uma conferência sobre Incerteza em Inteligência Artificial.

contar consenso

Os modelos tradicionais de aprendizado de máquina são treinados para executar tarefas específicas. Esses modelos normalmente fazem previsões específicas com base em suas entradas. Por exemplo, um modelo pode indicar se uma determinada imagem contém um gato ou um cachorro. Neste caso, avaliar a confiança requer simplesmente olhar para as previsões finais para ver se o modelo está correto.

No entanto, o modelo subjacente é diferente. O modelo é pré-treinado usando dados comuns em um ambiente onde o autor não conhece todas as tarefas posteriores às quais o modelo será aplicado. O usuário o adapta a uma tarefa específica após já ter sido treinado.

Ao contrário dos modelos tradicionais de aprendizado de máquina, o modelo subjacente não fornece resultados específicos, como rótulos como “gato” ou “cachorro”. Em vez disso, gera uma representação abstrata baseada em pontos de dados de entrada.

Para avaliar a confiabilidade do modelo subjacente, os pesquisadores usaram uma abordagem de conjunto que treina vários modelos que compartilham muitas características, mas são ligeiramente diferentes uns dos outros.

“Nossa ideia é como contar o consenso. Se todos esses modelos subjacentes fornecerem uma representação consistente para cada dado no conjunto de dados, então poderemos dizer que este modelo é confiável”, diz Park.

Mas eles encontraram um problema. Como podemos comparar representações abstratas?

“Esses modelos apenas geram vetores que implicam alguns números, portanto não podem ser facilmente comparados”, acrescentou.

Eles resolveram esse problema usando uma ideia chamada consistência de vizinhança.

Na sua abordagem, os investigadores preparam um conjunto de pontos de referência fiáveis para testar um conjunto de modelos. A seguir, para cada modelo, examinamos os pontos de referência que estão próximos da representação dos pontos de teste desse modelo.

Você pode estimar a confiabilidade do seu modelo examinando a consistência dos pontos adjacentes.

Alinhamento de expressão

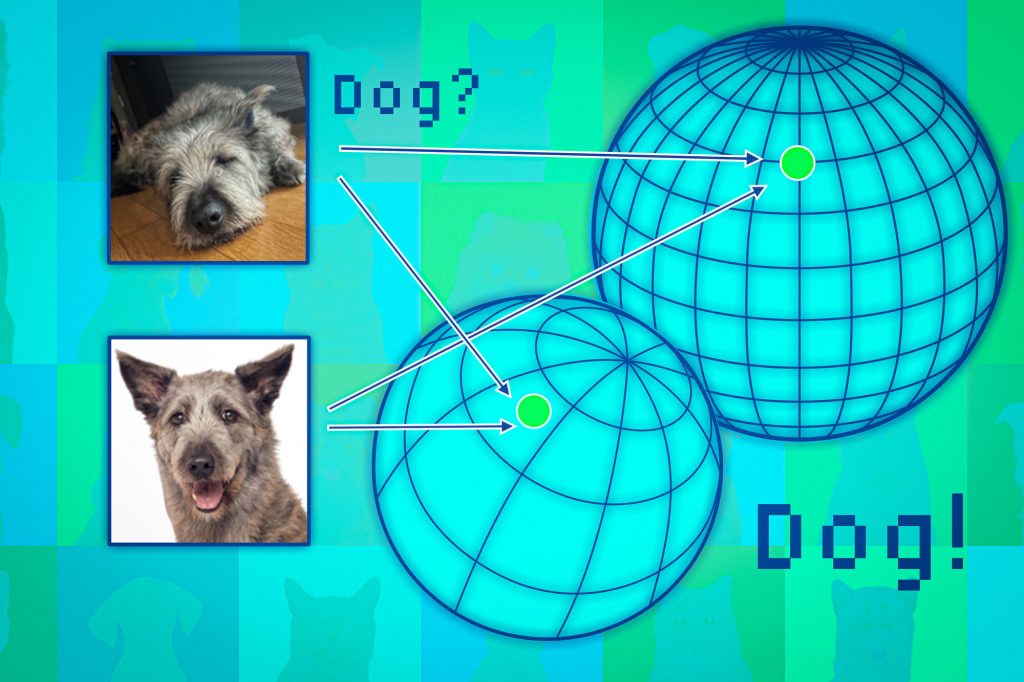

O modelo subjacente mapeia pontos de dados em um espaço conhecido como espaço de representação. Uma maneira de pensar neste espaço é como uma esfera. Cada modelo mapeia pontos de dados semelhantes para a mesma parte de sua esfera, de modo que a imagem do gato é colocada em um lugar e a imagem do cachorro é colocada em outro.

No entanto, cada modelo mapeia os animais de maneira diferente dentro de suas respectivas esferas, então é possível que uma esfera tenha gatos agrupados perto do pólo sul, enquanto outra possa mapeá-los em algum lugar do hemisfério norte.

Os pesquisadores usam pontos adjacentes como âncoras para alinhar as esferas para que suas representações possam ser comparadas. Se a vizinhança de um ponto de dados for consistente em diversas representações, você deverá ter confiança na confiabilidade da saída do modelo para esse ponto.

Testamos essa abordagem em diversas tarefas de classificação e descobrimos que ela é muito mais consistente do que a linha de base. Além disso, ele não foi prejudicado por pontos de teste difíceis que causaram falhas em outros métodos.

Além disso, como a sua abordagem pode ser utilizada para avaliar a fiabilidade de quaisquer dados de entrada, também pode ser utilizada para avaliar o desempenho de um modelo para tipos específicos de indivíduos, tais como pacientes com características específicas.

“Mesmo que todos os modelos tenham um desempenho geral médio, do ponto de vista de um indivíduo, você está escolhendo o melhor modelo para esse indivíduo”, diz Wang.

No entanto, as limitações surgem do fato de que grandes conjuntos de modelos subjacentes devem ser treinados, o que é computacionalmente caro. No futuro, pretendemos encontrar formas mais eficientes de construir múltiplos modelos, talvez utilizando pequenas perturbações de um único modelo.

Esta pesquisa foi financiada em parte pelo MIT-IBM Watson AI Lab, MathWorks e Amazon.