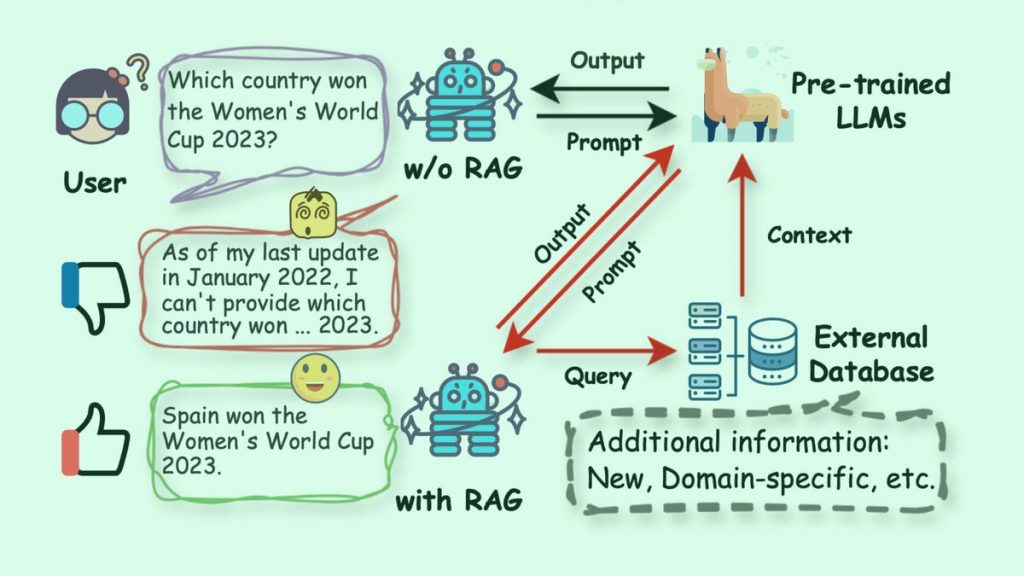

A representação do Baidu de uma abordagem RAG comum.

Baidu

Grande parte do interesse em torno da inteligência artificial (IA) centrou-se na batalha entre modelos concorrentes de IA em testes de referência e nas novas capacidades chamadas multimodais.

OpenAI revela Sora, um recurso de vídeo líder mundial, o Google responde com a capacidade do Gemini de selecionar quadros em um vídeo, e a comunidade de software de código aberto desenvolve rapidamente novas abordagens para superar com mais eficiência os programas comerciais dominantes.

Também: OpenAI está treinando um sucessor do GPT-4. Aqui estão três grandes atualizações que você pode esperar do GPT-5

No entanto, os utilizadores dos modelos de linguagem de grande escala da Gen AI, especialmente as empresas, provavelmente valorizarão uma abordagem equilibrada que produza respostas válidas rapidamente.

Um crescente corpo de pesquisas sugere que a tecnologia de geração de aumento de pesquisa (RAG) pode ser fundamental na definição da batalha entre modelos de linguagem de grande escala (LLMs).

RAG é uma forma de o LLM enviar solicitações a fontes de dados externas, como “bancos de dados vetoriais”, para responder a solicitações e recuperar dados confiáveis. O uso mais comum do RAG é reduzir a tendência dos LLMs de causar “alucinações” nas quais o modelo faz afirmações falsas com segurança.

Também: O OpenAI está suando? 9 recursos do Google anunciados para Gemini, Search, Android e muito mais

Fornecedores de software comercial, como o fabricante de software de pesquisa Elastic e o fornecedor de banco de dados Vector Pinecone, estão correndo para vender programas que permitem às empresas se conectar a bancos de dados e obter respostas confiáveis com base em coisas como os dados de produtos de uma empresa.

O conteúdo recuperado pode assumir vários formatos, como documentos de um banco de dados de documentos, imagens de arquivos de imagem ou vídeos e trechos de código de um repositório de código de desenvolvimento de software.

O que já está claro é que o paradigma de pesquisa será difundido em todos os LLMs, tanto em casos de uso comercial como de consumo. Todos os programas de IA generativa incluem ganchos para fontes externas de informação.

Atualmente, esse processo pode ser realizado com uma chamada de função. OpenAI e Anthropic contribuem para os programas GPT e Claude, respectivamente. Esses mecanismos simples fornecem acesso limitado aos dados para consultas limitadas, como obter a previsão do tempo atual em uma cidade.

As chamadas de função provavelmente precisarão ser mescladas ou substituídas por RAGs em algum momento para estender a funcionalidade que os LLMs podem fornecer em resposta.

Esta mudança significa que os RAGs se tornarão comuns no desempenho da maioria dos modelos de IA.

Também: CEO da Pinecone pretende dar à IA algo parecido com conhecimento

E essa excelência cria problemas. Neste estágio claramente inicial de desenvolvimento do RAG, o LLM se comporta de maneira diferente ao usar o RAG, e o software RAG lida melhor ou pior com as informações enviadas de volta ao LLM a partir do banco de dados. Esta diferença significa que o RAG representa um novo elemento na precisão e utilidade do LLM.

Os RAGs podem começar a influenciar as considerações de design do LLM já no estágio inicial de treinamento de um modelo de IA. Até agora, os modelos de IA foram desenvolvidos isoladamente e construídos como experiências científicas puras, com pouca ligação a outras partes da ciência de dados.

No futuro, poderá haver uma relação mais próxima entre a construção e o treinamento de redes neurais para IA generativa e as ferramentas downstream do RAG que desempenham um papel no desempenho e na precisão.

Armadilhas do LLM em relação à aquisição

Embora tenha sido demonstrado que a simples aplicação do RAG melhora a precisão do LLM, também pode introduzir novos problemas.

Por exemplo, algo que sai do banco de dados pode colocar o LLM em conflito, que é então resolvido por mais alucinações.

Também testei dezenas de chatbots de IA desde a estreia do ChatGPT. Aqui estão minhas novas principais escolhas

Pesquisadores da Universidade de Maryland descobriram em um relatório de março que o GPT-3.5 pode falhar mesmo após a recuperação de dados via RAG.

“Os sistemas RAG ainda podem ter dificuldades para fornecer informações precisas aos usuários se o contexto fornecido estiver além do escopo dos dados de treinamento do modelo”, escrevem eles. O LLM às vezes “produzia alucinações confiáveis ao interpolar o conteúdo factual”.

Os cientistas descobriram que as escolhas de design do LLM podem afetar o desempenho da pesquisa, incluindo a qualidade das respostas retornadas.

Um estudo realizado este mês por acadêmicos da Universidade de Pequim aponta que “a introdução da pesquisa aumentará inevitavelmente a complexidade do sistema e o número de hiperparâmetros a serem ajustados”, e hiperparâmetros são um termo usado para descrever como os LLMs são treinados. escolha que pode ser feita.

Você pode aumentar ou diminuir o escopo da pesquisa se o modelo escolher entre vários “tokens” possíveis, por exemplo, qual token escolher nos dados RAG. Isso significa quão amplo ou estreito é o conjunto de tokens que você escolhe.

A seleção de pequenos grupos, conhecida como “amostragem top-k”, “melhora a atribuição, mas compromete a fluência”, descobriram os acadêmicos de Pequim, e compensações como a qualidade e a relevância do conteúdo que os usuários recebem serão desativadas.

Como os RAGs podem expandir significativamente a chamada janela de contexto (o número total de caracteres ou palavras que o LLM tem que processar), o uso de RAGs pode tornar a janela de contexto do modelo um problema maior do que deveria ser.

Artigo relacionado: Melhor gerador de imagens de IA: testado e revisado

Alguns LLMs podem lidar com ainda mais tokens (cerca de 1 milhão no caso do Gemini), enquanto outros podem lidar com muito menos. Este facto por si só pode tornar alguns LLMs melhores no tratamento de RAGs do que outros.

Exemplos de hiperparâmetros e comprimento do contexto que influenciam os resultados decorrem do fato generalizado de que RAG e LLM têm “objetivos diferentes”, como observam os acadêmicos de Pequim. Eles são parafusados juntos em vez de montados juntos.

O RAG pode desenvolver tecnologia mais “avançada” para trabalhar melhor com o LLM. Alternativamente, você pode precisar incluir opções compatíveis com RAG em seu projeto de LLM no início do desenvolvimento do modelo.

Tentando tornar os LLMs mais inteligentes em relação aos RAGs

Os estudiosos recentemente passaram muito tempo estudando detalhadamente as falhas dos LLMs habilitados para RAG, com um objetivo sendo entender os fundamentos do que está faltando no próprio LLM e que causa problemas.

Cientistas da empresa chinesa de mensagens WeChat explicaram em um artigo de pesquisa de fevereiro que os LLMs não sabem necessariamente o que fazer com os dados que recuperam de seus bancos de dados. O modelo pode regurgitar informações incompletas fornecidas pelo RAG.

Além disso: OpenAI deu aos usuários do ChatGPT navegação gratuita, análise de dados e muito mais

“A principal razão é que o treinamento LLM não ensina explicitamente aos LLMs como explorar texto pesquisado de qualidade variável”, escrevem Shicheng Xu et al.

Para resolver esse problema, eles propuseram um método de treinamento especial para modelos de IA, que chamaram de “método de treinamento para melhoria da informação”, denominado INFO-RAG, e mostraram que ele pode melhorar a precisão do LLM usando os dados RAG.

O INFO-RAG do WeChat visa treinar modelos de linguagem em larga escala para reconhecer RAGs.

conversamos

A ideia do INFO-RAG é utilizar os dados adquiridos previamente no RAG como método de treinamento para o próprio LLM. O novo conjunto de dados é derivado de entradas da Wikipedia, dividido em fragmentos de frases, e o modelo é treinado para prever a segunda parte de uma frase, dada a primeira parte obtida do RAG.

Portanto, INFO-RAG é um exemplo de treinamento de LLM com RAG em mente. Dado que os LLMs são obrigados a utilizar RAGs em muitas situações, provavelmente veremos mais métodos de formação que incorporam RAGs externamente.

Aspectos mais sutis da interação entre RAG e LLM estão começando a surgir. Em abril, pesquisadores da fabricante de software ServiceNow descreveram como poderiam usar o RAG para contar com LLMs de pequena escala. Isso vai contra a ideia de que modelos de linguagem maiores são melhores.

“Um recuperador bem treinado pode reduzir o tamanho do LLM que o acompanha sem comprometer o desempenho, tornando as implantações de sistemas baseados em LLM menos intensivas em recursos”, escrevem Patrice Béchard e Orlando Marquezayala que estou escrevendo.

Além disso: O que é Copilot (anteriormente Bing Chat)?

Se os RAGs permitirem uma redução substancial do tamanho para muitos casos de uso, o foco do desenvolvimento do LLM poderá se afastar do paradigma de tamanho a todo custo dos modelos cada vez maiores de hoje.

Existem alternativas, mas existem problemas.

A alternativa mais provável é o ajuste fino, onde o modelo de IA é treinado novamente usando um conjunto de dados de treinamento mais focado após o treinamento inicial. Esse treinamento pode dar novas capacidades ao modelo de IA. Essa abordagem tem a vantagem de criar modelos que podem utilizar conhecimentos específicos codificados em pesos neurais sem depender de acesso a um banco de dados via RAG.

No entanto, o ajuste fino também tem seus próprios problemas. Cientistas do Google explicaram este mês que o ajuste fino tem fenômenos problemáticos, como a “maldição da confusão”, em que os modelos de IA não conseguem lembrar as informações de que precisam quando as informações estão incorporadas muito profundamente nos documentos de treinamento.

Este problema é um aspecto técnico de como os LLMs são inicialmente treinados e requer um trabalho especial para ser superado. Modelos de IA ajustados também podem enfrentar problemas de desempenho que resultam em diminuição do desempenho em comparação com o LLM simples.

O ajuste fino também inclui a necessidade de acessar e treinar novamente o código do modelo de linguagem. Este é um problema para usuários que não têm acesso ao código-fonte, como clientes da OpenAI ou outros fornecedores comerciais.

Além disso: esta ferramenta gratuita da Anthropic ajuda você a criar melhores prompts de IA

Conforme mencionado anteriormente, a chamada de função de hoje fornece uma maneira fácil para GPT ou Claude LLM responder a perguntas simples. O LLM transforma consultas em linguagem natural, como “Qual é o clima na cidade de Nova York?” Converta-o para um formato estruturado que inclua parâmetros como nomes e objetos de “temperatura”.

Esses parâmetros são passados para um aplicativo auxiliar especificado pelo programador, que retorna informações precisas. O LLM formata essas informações em uma resposta em linguagem natural, como “Atualmente estão 76 graus Fahrenheit na cidade de Nova York”.

No entanto, essa consulta estruturada limita o que o usuário pode fazer ou o que o LLM pode absorver como exemplos no prompt. O verdadeiro poder do LLM está em inserir consultas em linguagem natural e usá-las para extrair informações pertinentes de bancos de dados.

Uma abordagem mais simples do que ajustes e chamadas de função é conhecida como aprendizagem em contexto, e a maioria dos LLMs faz isso de qualquer maneira. A aprendizagem no contexto envolve a apresentação de instruções com exemplos que fornecem ao modelo demonstrações que reforçam o que ele pode fazer posteriormente.

A abordagem de aprendizagem em contexto foi estendida para o que é chamado de edição de conhecimento em contexto (IKE). O IKE tenta ajustar o modelo de linguagem para manter certos fatos (por exemplo, “Joe Biden”) no contexto por meio de instruções mediadas por demonstração. Perguntas como “Quem é o Presidente dos Estados Unidos?”

No entanto, a abordagem IKE ainda pode envolver o uso de RAGs, uma vez que os factos precisam de ser recuperados de algum lugar. Depender de prompts pode tornar o IKE um tanto vulnerável, uma vez que não há garantia de que novos fatos permanecerão nas informações de retenção do LLM.

estrada à frente

O aparente milagre do surgimento do ChatGPT em novembro de 2022 é o início de um longo processo de engenharia. Uma máquina que pode aceitar solicitações em linguagem natural e responder em linguagem natural deve estar equipada com uma forma de retornar respostas precisas e confiáveis.

A realização de tal integração levanta questões fundamentais sobre a adequação dos LLMs e quão bem os LLMs funcionam com programas RAG e vice-versa.

Como resultado, podem surgir subcampos de LLMs habilitados para RAG, construídos desde o início para incorporar conhecimento baseado em RAG. Essa mudança tem um grande impacto. Quando o conhecimento RAG é específico do domínio e da empresa, os LLMs habilitados para RAG são construídos mais perto dos usuários finais, em vez de serem criados como programas generalistas dentro das maiores empresas de IA, como OpenAI ou Google.

É seguro dizer que o RAG veio para ficar e a situação atual provavelmente exigirá que nos adaptemos a ele de diferentes maneiras.