Milhares de passageiros que passam por algumas das estações ferroviárias mais movimentadas da Grã-Bretanha foram escaneados por câmeras de IA que podem prever sua idade, sexo e até mesmo suas emoções.

Documentos recém-divulgados pela Network Rail, obtidos pela organização de liberdades civis Big Brother Watch, mostram que pessoas viajando por Londres Euston, Londres Waterloo, Manchester Piccadilly, Leeds e outras estações menores foram alertadas sobre o que revela como os rostos foram escaneados pelo software Amazon AI ao longo dos anos.

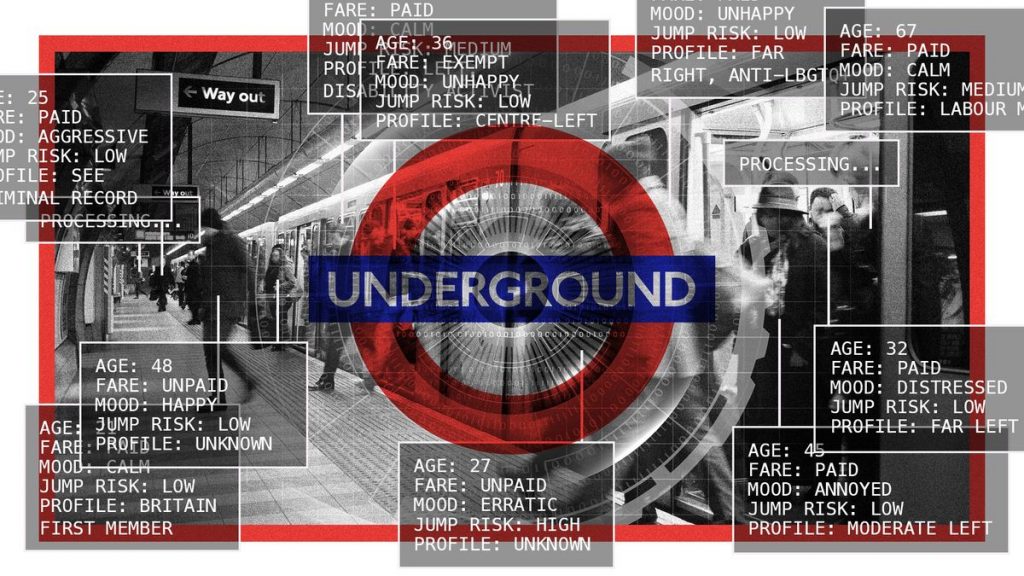

IA no transporte público do Reino Unido

O reconhecimento de objetos é um tipo de aprendizado de máquina que pode identificar itens em um feed de vídeo. Para a Network Rail, a tecnologia de vigilância de IA foi usada para analisar imagens de CFTV para alertar a equipe sobre incidentes de segurança, reduzir a evasão de tarifas e melhorar a eficiência da estação.

aplicar 1 semana

Fuja da câmara de eco. Obtenha os fatos por trás das notícias e análises de múltiplas perspectivas.

Inscreva-se e salve

Inscreva-se no boletim informativo gratuito desta semana

Do nosso briefing matinal ao nosso boletim informativo semanal de boas notícias, receba as melhores histórias da semana diretamente na sua caixa de entrada.

Do nosso briefing matinal ao nosso boletim informativo semanal de boas notícias, receba as melhores histórias da semana diretamente na sua caixa de entrada.

A Transport for London (TfL) também está testando câmeras alimentadas por IA, e os resultados são “surpreendentes” e “revelando possibilidades para melhor ou pior”, disse James O’Malley, da revista House.

Um teste de duas semanas em 2019 viu câmeras especiais de IA treinadas em bilheterias detectarem se mais pessoas estavam na fila para entrar ou sair de uma estação, de acordo com um pedido de Liberdade de Informação (FoI). mudar automaticamente a direção da bilheteria. Como resultado, o tráfego de passageiros aumentou 30% e os tempos de espera foram reduzidos em até 90%.

Uma tentativa recente mais ambiciosa em Willesden Green, no noroeste de Londres, usou software de IA para transformar feeds CCTV em “estações inteligentes” que poderiam descobrir até 77 “casos de uso” diferentes. Estes variavam desde jornais descartados até pessoas que estavam muito perto da borda da plataforma e eram usados para reduzir a evasão de tarifas e alertar o pessoal sobre comportamento agressivo.

Os perigos da “IA emocional”

Uma das seções mais atraentes do documento da Network Rail explica como o sistema Rekognition da Amazon, que permite a análise de rostos e objetos, é “implantado para prever a idade, o sexo e as emoções subjacentes dos viajantes”. dados poderiam ser usados. em futuros sistemas de publicidade”, disse Wired.

O documento afirma que a capacidade da IA de classificar expressões faciais como felicidade ou raiva poderia ser usada para reconhecer a satisfação do cliente e que “esses dados podem ser usados para maximizar a receita de publicidade e varejo”.

Os pesquisadores de IA “frequentemente alertam que o uso de técnicas para detectar emoções não é confiável”, relatou a Wired.

“Devido à natureza subjetiva das emoções, a IA emocional é particularmente suscetível a preconceitos”, diz Harvard Business Review. Além disso, a IA muitas vezes “não é sofisticada o suficiente para compreender as diferenças culturais na expressão e leitura de emoções, tornando difícil tirar conclusões precisas”.

Carissa Bellis, professora associada de psicologia do AI Ethics Institute da Universidade de Oxford, disse à Wired que usar IA para ler emoções é uma “ladeira escorregadia”.

A expansão da vigilância, diz ela, é uma resposta a um impulso “instintivo”. “Os humanos querem ver mais e mais longe, mas a vigilância leva ao controlo, e o controlo leva à perda de liberdade que ameaça a democracia liberal.”

O'Malley disse que as “estações inteligentes” alimentadas por IA têm o potencial de tornar a experiência do passageiro “mais segura, mais limpa e mais eficiente”, mas que o uso do reconhecimento de imagem “tem o direito de ser usado com conveniência e eficiência”. é necessário um delicado equilíbrio entre a protecção dos

Por exemplo, “não há razão técnica para que este tipo de câmara não possa ser usada para identificar indivíduos através do reconhecimento facial ou para encontrar certos símbolos políticos”, disse ele.