Pesquisadores de segurança cibernética descobriram uma falha crítica de segurança no provedor de inteligência artificial (IA) Replicate as a service. Essa falha poderia ter permitido que um invasor acessasse modelos proprietários de IA e informações confidenciais.

“Essa vulnerabilidade, se explorada, poderia ter permitido acesso não autorizado a prompts e resultados de IA para todos os clientes da plataforma Replicate”, disse a empresa de segurança em nuvem Wiz em um relatório divulgado esta semana.

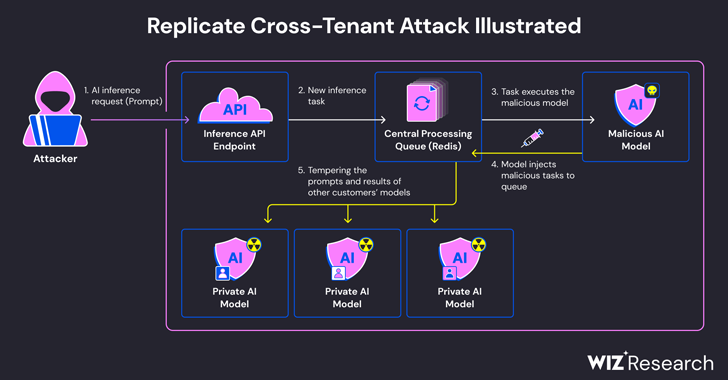

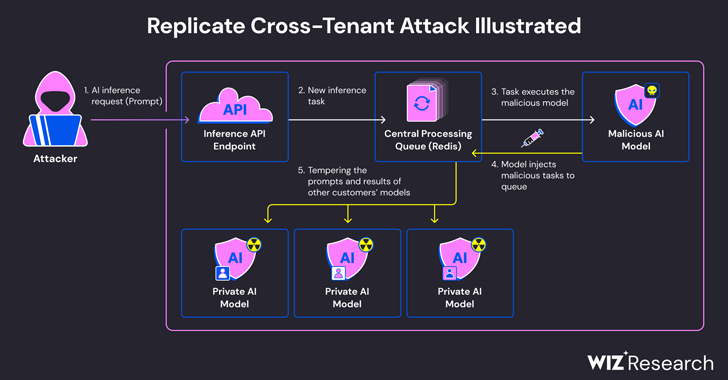

O problema é que os modelos de IA são normalmente empacotados em um formato que permite a execução de código arbitrário, e os invasores podem usar modelos maliciosos para transformá-los em armas para realizar ataques entre locatários.

O Replicate aproveita uma ferramenta de código aberto chamada Cog para conteinerizar e empacotar seus modelos de aprendizado de máquina e implantá-los em um ambiente auto-hospedado ou no Replicate.

De acordo com Wiz, eles criaram um contêiner Cog desonesto, carregaram-no no Replicate e, por fim, usaram-no para permitir a execução remota de código com privilégios elevados na infraestrutura do serviço.

Os pesquisadores de segurança Shir Tamari e Sagi Tzadik disseram: “Suspeitamos que essa técnica de execução de código seja um padrão no qual empresas e organizações executam modelos de IA a partir de fontes não confiáveis, mesmo que esses modelos sejam potencialmente maliciosos. .”

O método de ataque desenvolvido pela empresa aproveitou conexões TCP já estabelecidas associadas a instâncias de servidor Redis em clusters Kubernetes hospedados no Google Cloud Platform para injetar comandos arbitrários.

Além disso, como um servidor Redis gerenciado centralmente é usado como uma fila para gerenciar diversas solicitações de clientes e suas respostas, tarefas não autorizadas podem interferir no processo e afetar os resultados de outras tarefas. A inserção pode ser explorada para facilitar ataques entre locatários. modelo de cliente.

Estas operações não autorizadas não só ameaçam a integridade do modelo de IA, mas também representam um risco significativo para a precisão e fiabilidade dos resultados orientados pela IA.

“Um invasor pode consultar o modelo privado de IA de um cliente e vazar conhecimento proprietário ou dados confidenciais relacionados ao processo de treinamento do modelo”, disseram os pesquisadores. “Além disso, a interceptação de prompts pode expor dados confidenciais, incluindo informações de identificação pessoal (PII).

Este próximo problema foi divulgado de forma responsável em janeiro de 2024 e desde então foi abordado pela Replicate. Não há evidências de que esta vulnerabilidade tenha sido explorada para comprometer os dados dos clientes.

Esta divulgação ocorre pouco mais de um mês depois que Wiz detalhou os riscos que agora estão sendo corrigidos em plataformas como Hugging Face. Este risco pode permitir que um invasor aumente privilégios, obtenha acesso entre locatários aos modelos de outros clientes e até mesmo assuma a integração contínua ou a implantação contínua. pipeline (CI/CD).

“Os modelos maliciosos representam um risco significativo para os sistemas de IA, especialmente para os fornecedores de IA como serviço, uma vez que os atacantes podem aproveitar estes modelos para realizar ataques entre inquilinos”, concluíram os investigadores.

“O impacto potencial é devastador, pois um invasor pode obter acesso a milhões de modelos e aplicativos privados de IA armazenados em provedores de IA como serviço.”