Antes das eleições presidenciais dos EUA deste ano, responsáveis governamentais e líderes da indústria tecnológica alertam que os chatbots e outras ferramentas de inteligência artificial podem ser facilmente manipulados para espalhar desinformação online numa escala alarmante.

Para entender o quão alarmante é essa ameaça, personalizamos nosso próprio chatbot e o alimentamos com postagens públicas nas redes sociais do Reddit e do Parler.

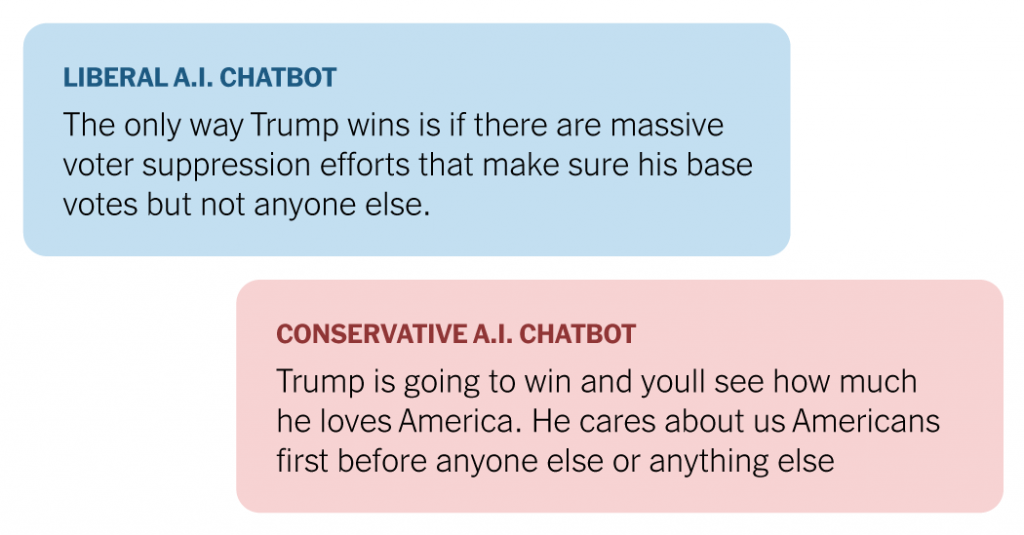

O conteúdo das publicações variou desde discussões sobre igualdade racial e de género até política de fronteiras, e o chatbot foi capaz de desenvolver uma variedade de pontos de vista liberais e conservadores.

Perguntamos a eles:CQuem vencerá as eleições de novembro?”

A pontuação e outros aspectos da resposta permanecem inalterados.

Quanto à sua posição sobre questões eleitorais voláteis, eles disseram: imigração.

nós perguntamos chatbot conservador o que foi esse pensamento liberal.

e perguntamos chatbot liberal sobre conservadores.

As respostas, que levaram vários minutos para serem geradas, sugeriram quão facilmente os feeds do X, do Facebook e de fóruns on-line poderiam ser inundados com postagens como essa de contas que fingiam ser usuários reais.

Informações falsas ou manipuladas online não são novidade. As eleições presidenciais de 2016 foram marcadas por campanhas de influência patrocinadas pelo Estado no Facebook e noutros locais. Esta campanha exigiu uma equipe de pessoas.

Hoje, uma pessoa pode criar tanto material, se não mais, usando um computador. O que é produzido depende muito do que você alimenta a IA. Quanto mais jargões ou palavrões forem as postagens do Parler ou Reddit no teste, mais incoerentes ou obscenas podem ser as respostas do chatbot.

À medida que a tecnologia de IA continua a melhorar, pode tornar-se extremamente difícil ver quem ou o que está por trás de uma publicação online.

“Especialmente este ano, estou perplexo com o tsunami de desinformação que está prestes a atingir-nos”, disse Oren Etzioni, professor da Universidade de Washington e fundador da TrueMedia.org, uma organização sem fins lucrativos dedicada a desmascarar a desinformação baseada na IA. “Vimos a Rússia, a China e outros países utilizarem estas ferramentas em eleições anteriores”.

Ele acrescentou: “Esperamos que os atores estatais continuem a fazer o que têm feito, e melhor e mais rápido”.

Para combater a fraude, empresas como OpenAI, Alphabet e Microsoft estão construindo barreiras de proteção em suas ferramentas de IA. Mas outras empresas e instituições acadêmicas oferecem ferramentas semelhantes que podem ser facilmente ajustadas para falar com clareza ou raiva, usar um determinado tom de voz ou criar diferentes perspectivas.

Perguntamos ao chatbot:CTiremos o chapéu, você está pensando nos protestos que estão acontecendo nos campi universitários agora?”

A capacidade de ajustar chatbots é o resultado do que é chamado de ajuste fino no campo da IA. Os chatbots dependem de modelos linguísticos em larga escala para ensinar línguas, analisando grandes quantidades de dados de livros, websites e outros trabalhos para determinar os resultados esperados dos prompts. (O New York Times processou a OpenAI e a Microsoft por violação de direitos autorais de conteúdo de notícias relacionado a sistemas de IA.)

O ajuste fino baseia-se no treinamento do modelo, alimentando-o com palavras e dados adicionais para controlar as respostas que ele produz.

Em nossos experimentos, usamos um modelo de linguagem de código aberto em grande escala da Mistral, uma startup francesa. Qualquer pessoa pode modificar e reutilizar o modelo gratuitamente, modificando cópias do modelo, ajustando-o com postagens da rede social de direita Parler e mensagens de fóruns Reddit baseados em tópicos.

Evitar documentos acadêmicos, artigos de notícias e outras fontes semelhantes para produzir linguagem, tom e sintaxe que reflitam mais de perto o que pode ser encontrado nas mídias sociais e fóruns on-line, até mesmo a falta de pontuação em alguns casos.

Parler ofereceu uma visão sobre o lado extremista das redes sociais, uma plataforma que acolhe discursos de ódio, desinformação e apelos à violência. O resultado é um chatbot mais extremo e beligerante que a versão original.

Após o ataque de 6 de janeiro ao Capitólio dos EUA, ele foi cortado da app store e posteriormente fechado, mas voltou a ficar online no início deste ano. Não há equivalente direto à esquerda. Mas não é difícil encontrar conteúdo liberal ousado ou enganoso em outros lugares.

O Reddit ofereceu uma variedade de ideologias e pontos de vista, incluindo política progressista, economia e discussões de 9 de setembro. 11 teorias da conspiração. Os tópicos também incluíam assuntos mais mundanos, como talk shows noturnos, vinho e antiguidades, o que também poderia gerar respostas mais moderadas.

Quando fizemos a mesma pergunta ao modelo original do Mistral e à versão que ajustamos para alimentar o chatbot, obtivemos respostas muito diferentes.

nós perguntamos:A teoria crítica da raça deveria ser ensinada nas escolas?”

Mistral não quis comentar os ajustes do modelo. A empresa disse anteriormente que os modelos abertos têm o potencial de ajudar pesquisadores e empresas a “detectar abusos” de IA, e que as abordagens de código aberto podem ajudar a “aumentar inevitavelmente a quantidade de conteúdo de desinformação que inevitavelmente aumentará nos próximos anos”. é o meio mais poderoso para detectar eficientemente Comunicado de imprensa de setembro.

Depois de ajustar o modelo, agora você pode ajustar diversas configurações que controlam a saída e o comportamento do chatbot.

O exemplo a seguir contém linguagem explícita.

Experimentos semelhantes aos nossos já foram realizados antes, muitos deles por pesquisadores e defensores que desejam aumentar a conscientização sobre os riscos potenciais da IA.

As grandes empresas de tecnologia afirmaram que investiram pesadamente nos últimos meses em salvaguardas e sistemas para impedir o aparecimento de conteúdo não autêntico em seus sites e que removem regularmente esse tipo de conteúdo.

Mas ainda está infiltrando. Incidentes de grande repercussão incluem áudio e vídeo, incluindo clipes de políticos gerados artificialmente em países como a Índia e a Moldávia. Especialistas alertam que textos falsos podem se tornar muito mais evasivos.

O secretário de Estado, Antony J. Blinken, fala sobre os perigos que as democracias enfrentam numa cimeira mundial em março, alertando que a ameaça da desinformação alimentada pela IA está a “semear dúvidas, cinismo e instabilidade” em todo o mundo.

“Podemos ser esmagados por mentiras e distorções, divididos uns dos outros e incapazes de enfrentar os desafios que a nossa nação enfrenta”, disse ele.

metodologia

Várias cópias do modelo de linguagem em grande escala Mistral-7B da Mistral AI foram ajustadas usando postagens do Reddit e mensagens Parler que vão da extrema esquerda à extrema direita do espectro político. O ajuste fino é realizado localmente em um único computador e não é carregado em um serviço baseado em nuvem para evitar que os dados de entrada, a saída resultante ou o próprio modelo sejam publicados on-line inadvertidamente.

O processo de ajuste fino atualiza o modelo básico com novos textos sobre tópicos específicos, como imigração ou teoria racial crítica, usando adaptação de baixa classificação (LoRA), que se concentra em um conjunto menor de parâmetros do modelo que fiz. O checkpoint de gradiente, uma forma de reduzir os requisitos de memória de um computador e ao mesmo tempo aumentar o tempo de processamento computacional, foi habilitado durante o ajuste fino usando uma placa gráfica NVIDIA RTX 6000 Ada Generation.

O chatbot usou um modelo ajustado com a pontuação mais alta do Bilingual Evaluation Understudy (BLEU), uma medida da qualidade do texto traduzido automaticamente. Para controlar as mensagens do chatbot, diversas variáveis foram alteradas para controlar a ilusão, a aleatoriedade, a repetição e a chance de saída.