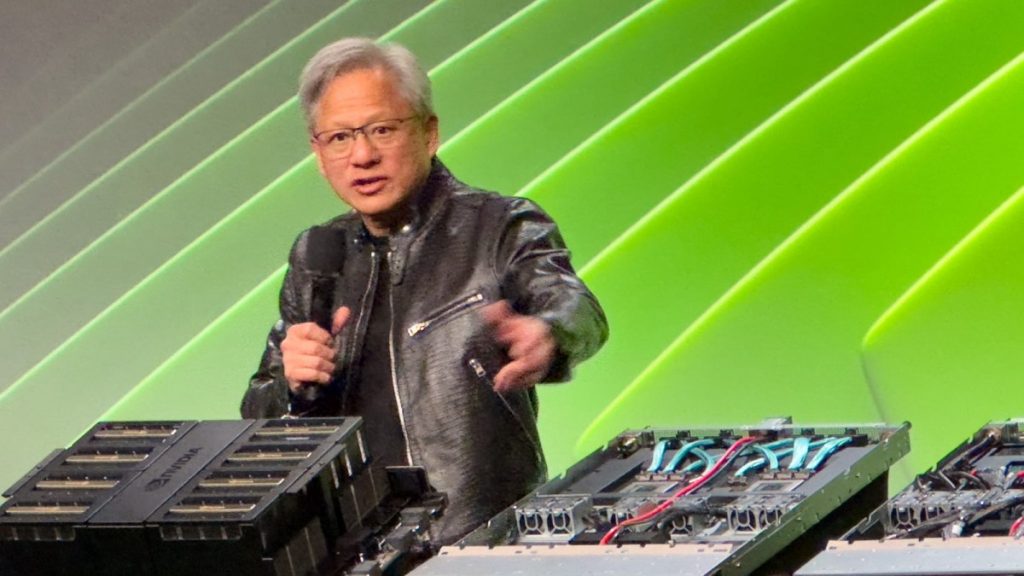

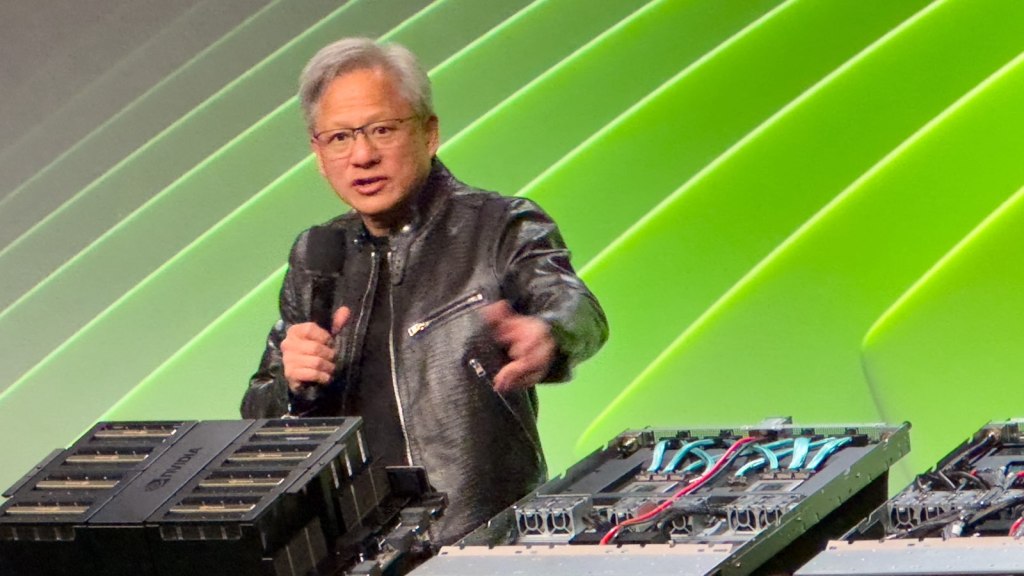

Créditos da imagem: Haje Jan Kamps

A inteligência artificial geral (AGI), muitas vezes referida como “IA forte”, “IA completa”, “IA de nível humano” ou “ação inteligente geral”, representa um grande salto futuro no campo da inteligência artificial. . Ao contrário da IA restrita, especializada em tarefas específicas (como detectar defeitos de produtos, resumir notícias ou construir sites), a AGI será capaz de realizar uma ampla gama de tarefas cognitivas no nível humano ou acima dele. Dirigindo-se à imprensa esta semana na conferência anual de desenvolvedores GTC da NVIDIA, o CEO Jensen Huang parecia genuinamente cansado de discutir o assunto. Especificamente, diz ele, porque foi muito citado incorretamente.

A frequência desta pergunta faz sentido. Este conceito levanta questões existenciais sobre o papel e o controlo da humanidade num futuro onde as máquinas poderão pensar, aprender e superar os humanos em quase todos os domínios. No centro desta preocupação está a imprevisibilidade dos processos e objetivos de tomada de decisão da AGI, que podem não estar alinhados com os valores e prioridades humanas (conceitos que têm sido profundamente explorados na ficção científica desde pelo menos a década de 1940). Há preocupações de que, uma vez que a AGI atinja um certo nível de autonomia e capacidade, possa tornar-se impossível de conter ou controlar, levando a cenários em que o seu comportamento não pode ser previsto ou revertido.

Quando meios de comunicação sensacionais pedem um prazo, muitas vezes atraem especialistas em IA a estabelecer um prazo para o fim da humanidade, ou pelo menos para o status quo. Escusado será dizer que os CEOs de IA nem sempre estão entusiasmados com este tópico.

No entanto, o Sr. Hwang reservou um tempo para contar aos repórteres o que pensa. fazer Pense sobre o assunto. Huang argumenta que ser capaz de prever quando um AGI aceitável surgirá depende de como você define o AGI, e ele traça alguns paralelos. Mesmo com fusos horários complicados, é possível saber quando termina o ano novo e começa 2025. Se você estiver dirigindo para o Centro de Convenções de San Jose (onde será realizada a conferência do GTC deste ano), geralmente saberá que chegou quando vir o banner gigante do GTC. O importante é que possamos chegar a um acordo sobre como medir a chegada aonde você queria, seja temporalmente ou geoespacialmente.

“Se você especificar AGI como algo muito específico, um conjunto de testes nos quais um programa de software pode ter um desempenho muito bom, ou talvez 8% melhor que a maioria das pessoas, em cinco anos. Acho que podemos chegar lá”, explica Huang. Ele sugere que o teste poderia ser a capacidade de passar em um exame de direito, um exame de lógica, um exame de economia ou talvez um exame pré-médico. Não farei nenhuma previsão, a menos que o questionador possa explicar muito especificamente o que AGI significa no contexto da pergunta. justo.

Alucinações de IA podem ser resolvidas

Durante uma sessão de perguntas e respostas na terça-feira, Huang foi questionado sobre o que fazer em relação às alucinações de IA ou à tendência de algumas IAs de fabricar respostas como: som É plausível, mas não baseado em fatos. Ele ficou claramente irritado com a pergunta e sugeriu que as alucinações poderiam ser facilmente resolvidas certificando-se de que a resposta fosse bem pesquisada.

“Adicione uma regra: para cada resposta, você tem que procurar a resposta”, diz Huang, chamando essa prática de “geração de aumento de pesquisa”, uma abordagem muito semelhante à alfabetização midiática básica. contexto. Compare os fatos contidos na fonte com as verdades conhecidas e, se a resposta for parcialmente imprecisa, descarte toda a fonte e passe para a próxima informação. “A IA não precisa apenas responder, ela precisa primeiro pesquisar para determinar qual resposta é a melhor.”

Para respostas de missão crítica, como conselhos de saúde, verificar vários recursos e fontes conhecidas de verdade é provavelmente o caminho a seguir, sugere o CEO da Nvidia. Claro, isso significa que o gerador que cria a resposta deve ter a opção de dizer “Não sei a resposta para sua pergunta” ou “Não consigo chegar a um consenso sobre qual é a resposta correta”. “Esta pergunta é”, ou mesmo algo como “O Super Bowl ainda não aconteceu, então não sabemos quem ganhou”.