O CEO Jensen Hwang disse que a NVIDIA continuará a desenvolver tecnologia de IA, apesar dos rivais perderem participação de mercado e de um dos principais fornecedores da NVIDIA dar uma previsão modesta para vendas de chips de IA. Ele continuará sendo o padrão ouro para chips de treinamento, disse ele aos investidores.

Todos, desde OpenAI até Tesla de Elon Musk, dependem de semicondutores Nvidia para executar modelos de linguagem e visão computacional em larga escala. Huang disse na reunião anual de acionistas da empresa na quarta-feira que sua liderança se fortalecerá ainda mais com a introdução dos sistemas Blackwell da NVIDIA ainda este ano.

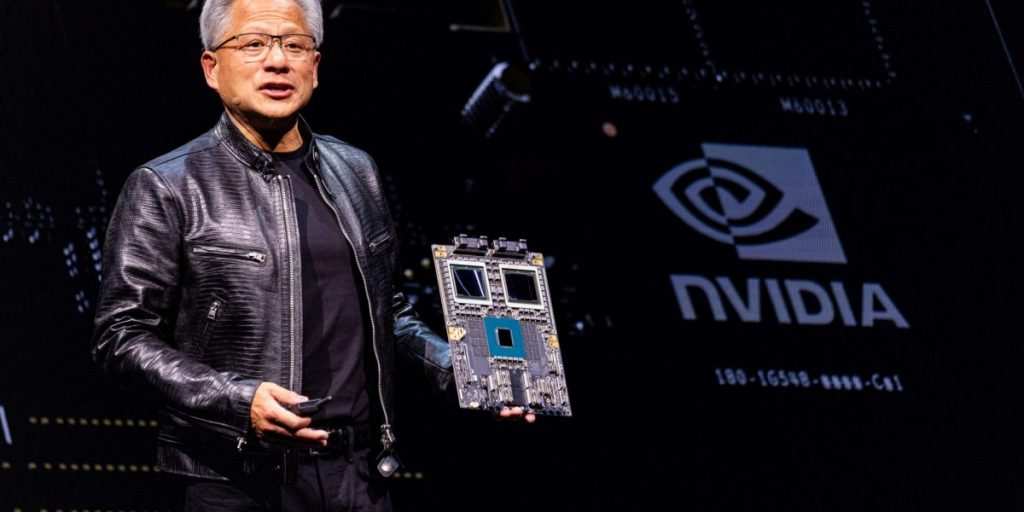

Anunciado em março, Blackwell é a próxima geração de processadores de treinamento de IA seguindo a principal linha Hopper de chips H100. O chip H100 é um dos ativos mais valiosos da indústria de tecnologia, sendo vendido por dezenas de milhares de dólares cada.

“A plataforma de arquitetura Blackwell será provavelmente o produto de maior sucesso em nossa história e até mesmo em toda a história da computação”, disse Huang.

A Nvidia ultrapassou brevemente a Microsoft e a Apple este mês para se tornar a empresa mais valiosa do mundo, numa recuperação impressionante que impulsionou grande parte dos ganhos do S&P 500 este ano. A empresa de Hwang foi avaliada em mais de 3 biliões de dólares, valendo a certa altura mais do que toda a economia e o mercado de ações, mas o seu valor de mercado sofreu uma queda recorde à medida que os investidores obtinham lucros.

Mas enquanto os chips da Nvidia continuarem sendo a referência para o treinamento de IA, há poucos motivos para acreditar que as perspectivas de longo prazo sejam nebulosas e os fundamentos continuem a parecer sólidos.

Uma das principais vantagens da Nvidia é seu ecossistema de IA conhecido como CUDA, que significa Compute Unified Device Architecture. Assim como os consumidores comuns relutam em mudar de dispositivos Apple iOS para telefones Samsung usando Google Android, uma população inteira de desenvolvedores usa CUDA há anos e se sente muito confortável com isso, há poucos motivos para considerar o uso de outra plataforma de software. Assim como o hardware, o CUDA tornou-se efetivamente seu próprio padrão.

“A plataforma Nvidia está amplamente disponível em todos os principais provedores de nuvem e fabricantes de computadores, criando uma base grande e atraente para desenvolvedores e clientes, tornando nossa plataforma ainda mais valiosa para nossos clientes”, acrescentou Huang na quarta-feira.

A orientação inline da Micron sobre os lucros do próximo trimestre não é suficiente para os touros

A Micron Technology, fornecedora de chips de memória que fornece chips de memória de alta largura de banda (HBM) para empresas como a Nvidia, disse que espera que as vendas fiscais do quarto trimestre atendam apenas às expectativas do mercado de cerca de US$ 7,6 bilhões. O comércio de IA sofreu recentemente.

O preço das ações da Micron despencou 7%, bem abaixo dos ganhos modestos do índice Nasdaq Composite, de alta tecnologia.

No passado, a Micron e seus rivais coreanos Samsung e SK Hynix experimentaram os altos e baixos cíclicos comuns ao mercado de chips de memória, que há muito é considerado um negócio de commodities em comparação com chips lógicos, como processadores gráficos.

Mas há entusiasmo, dada a procura por chips necessários para o treino de IA. mícron O preço das ações mais que dobrou nos últimos 12 meses. Isto significa que os investidores já avaliaram grande parte do crescimento esperado pela gestão.

“A orientação está basicamente alinhada com as expectativas e, no mundo do hardware de IA, se você receber uma orientação alinhada com isso, será uma pequena decepção”, disse Gene Munster, investidor em tecnologia da Deepwater Asset Management. “Os investidores dinâmicos simplesmente não viam nenhuma razão para serem mais positivos em relação a esta história.”

Os analistas acompanham de perto a demanda por memória de alta largura de banda como um indicador importante na indústria de IA. Isto porque é fundamental para resolver o problema do escalonamento, que é o maior constrangimento económico que a formação em IA enfrenta actualmente.

Chip HBM aborda problemas de escala para treinamento de IA

Os custos não aumentam com a complexidade do modelo (o número de parâmetros que um modelo possui, que pode chegar a bilhões), mas aumentam exponencialmente. Isso reduz os retornos de eficiência ao longo do tempo.

Mesmo que as receitas cresçam a uma taxa constante, existe o risco de que as perdas aumentem para milhares de milhões ou mesmo dezenas de milhares de milhões por ano à medida que os modelos se tornam mais sofisticados. Isto ameaça sobrecarregar as empresas que não têm investidores endinheirados como a Microsoft, onde a OpenAI ainda pode “pagar as contas”, como disse recentemente o CEO Sam Altman.

A principal razão para os retornos decrescentes é o fosso cada vez maior entre os dois factores que determinam o desempenho do treino de IA. O primeiro é o poder de computação bruto de um chip lógico (medido em FLOPS, um tipo de cálculo por segundo), e o segundo é a largura de banda de memória necessária para fornecer dados rapidamente, geralmente 1 Expresso em milhões de transferências por segundo (MT/s ).

Eles trabalham juntos, portanto, dimensionar um sem o outro simplesmente cria desperdício e não é rentável. Portanto, a utilização de FLOPS, ou a quantidade de computação que pode realmente ser executada, é uma métrica chave para determinar a eficiência de custos de um modelo de IA.

Esgotado até o final do próximo ano

Como aponta a Micron, as taxas de transferência de dados não conseguem mais acompanhar o aumento do poder computacional. O gargalo resultante é frequentemente chamado de “parede de memória” e é uma importante fonte da ineficiência inerente de hoje no dimensionamento de modelos de treinamento de IA.

Isso explica por que o governo dos EUA se concentrou na largura de banda da memória ao decidir quais chips Nvidia deveriam ser proibidos de exportar para a China, a fim de minar o programa de desenvolvimento de IA do governo chinês que estou explicando.

A Micron anunciou na quarta-feira que seu negócio HBM está “esgotado” até o final do próximo ano civil, um quarto atrás do ano fiscal, ecoando comentários semelhantes da rival sul-coreana SK Hynix.

“Esperamos gerar centenas de milhões de dólares em receitas da HBM no ano fiscal de 2024. [billions of dollars] “Esperamos ver um aumento significativo na receita da HBM no ano fiscal de 25”, disse Micron na quarta-feira.