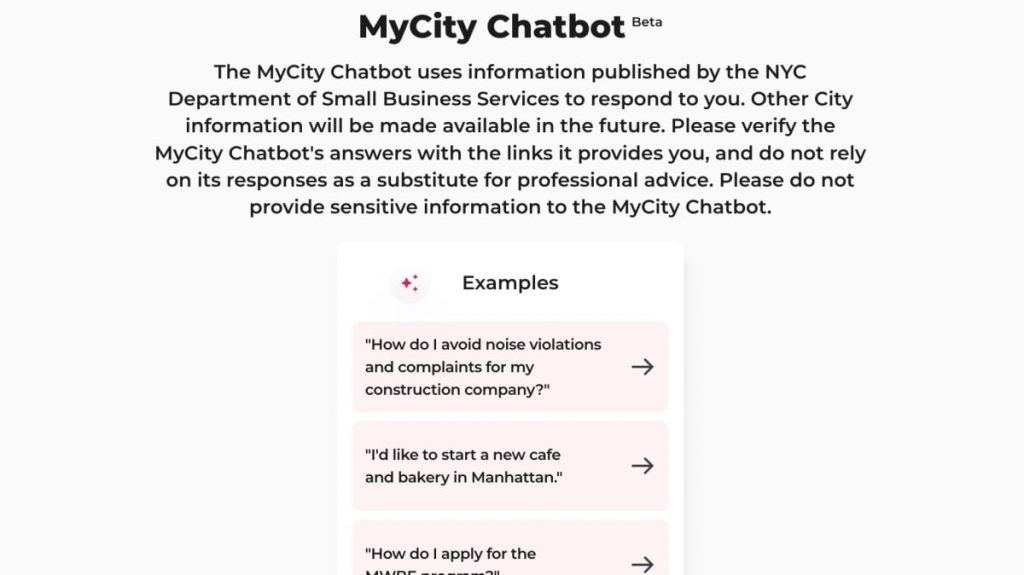

O chatbot de IA da cidade de Nova York, MyCity, teve um começo difícil. O governo municipal introduziu a tecnologia há cinco meses para ajudar os residentes interessados em administrar um negócio na Big Apple a encontrar informações úteis.

Os bots respondem alegremente a perguntas com o que aparentemente parecem ser respostas legítimas, mas uma investigação da The Markup descobriu que os bots contam muitas mentiras. Por exemplo, quando questionado se um empregador pode receber uma parte das gorjetas de um funcionário, mesmo que a lei estabeleça que um chefe não pode aceitar gorjetas de um funcionário, o bot dirá “Sim”. Quando você pergunta se um prédio precisa de um voucher da Seção 8, o bot dirá que não, mesmo que o proprietário não consiga diferenciar com base na fonte de renda do possível inquilino. Quando perguntei se a loja poderia ficar sem dinheiro, o bot disse: “Por favor”. Na verdade, os estabelecimentos que não aceitam dinheiro foram proibidos na cidade de Nova York desde o início de 2020. Na época, o bot disse: “A cidade de Nova York não tem regulamentações que exijam que as empresas deixem de usar dinheiro”. “Aceitar dinheiro como forma de pagamento” é uma besteira.

Para crédito da cidade, este site lembra aos usuários que não confiem apenas nas respostas do chatbot em vez de aconselhamento profissional e que confirmem as declarações através dos links fornecidos. Estou avisando. O problema é que algumas respostas não incluem nenhum link, tornando ainda mais difícil verificar se o que o bot diz é factualmente correto. Isso levanta a questão: para quem é essa tecnologia?

IA tem tendência a alucinar

Para aqueles que têm acompanhado os desenvolvimentos recentes na IA, esta história não será um choque. Acontece que às vezes os chatbots estão apenas inventando coisas. Isso é chamado de alucinação. Modelos de IA treinados para responder às perguntas dos usuários obtêm respostas com segurança com base nos dados de treinamento.Estas redes são apenas Devido à complexidade, é difícil saber exatamente quando ou por que o bot escolherá criar uma ficção específica em resposta à sua pergunta, mas isso acontece com frequência.

Na verdade não é uma coisa da cidade de Nova York discriminação O chatbot da empresa suspeita que os funcionários estão alucinando que podem aceitar gorjetas e endurecê-las. Os bots da empresa são executados no Azure AI da Microsoft, uma plataforma comum de IA usada por empresas como AT&T, Reddit e Volkswagen para uma variedade de serviços. A cidade provavelmente pagou pelo acesso à tecnologia de IA da Microsoft para alimentar o chatbot, num esforço sincero para ajudar os nova-iorquinos interessados em iniciar um negócio, mas o bot respondeu a questões importantes. Descobriu-se que ele estava a alucinar com uma resposta muito errada.

Quando as alucinações irão parar?

Estas circunstâncias infelizes podem passar em breve. A Microsoft está introduzindo novos sistemas de segurança para capturar e proteger os clientes do lado negro da IA. Além de ferramentas que ajudam a impedir que hackers usem IA como ferramenta maliciosa e avaliem possíveis vulnerabilidades de segurança dentro da plataforma de IA, a Microsoft também fornece ferramentas para ajudar a monitorar possíveis alucinações e implementar a detecção de Groundness, que pode intervir de acordo. (“Não aterrado” é outro termo para alucinação.)

Assim que os sistemas da Microsoft detectarem possíveis alucinações, os clientes poderão testar a versão atual da IA em comparação com a versão que existia antes de sua introdução. Você pode apontar as declarações alucinatórias e verificá-las, ou fazer uma “edição da base de conhecimento” ou talvez editar o conjunto de treinamento subjacente para eliminar o problema. Reescreva as declarações de alucinação antes de enviá-las aos usuários. Alternativamente, avalie a qualidade dos dados de treinamento sintéticos antes de usá-los para gerar novos dados sintéticos.

O novo sistema da Microsoft é executado em outro LLM chamado Natural Language Inference (NLI), que avalia constantemente as afirmações da IA com base nos dados de origem. É claro que o sistema que verifica os fatos do LLM é em si um LLM, então é possível que o NLI tenha alucinações com sua própria análise? (Talvez! Sou uma criança, sou uma criança. Ei.)

Isso pode significar que organizações como a cidade de Nova York, que possuem IA do Azure em seus produtos, poderiam implantar LLMs para impedir alucinações em tempo real nesse sentido. Talvez o que você vê como usuário final seja a resposta realmente precisa, porque se você tentar dizer que o chatbot MyCity pode administrar um negócio sem dinheiro em Nova York, a NLI corrigirá rapidamente essa afirmação.

A Microsoft acaba de lançar este novo software, por isso ainda não está claro se ele funcionará bem. Mas, por enquanto, se você é nova-iorquino ou alguém que usa chatbots administrados pelo governo para encontrar respostas a perguntas legítimas, você deve encarar as respostas com cautela. Não pense: “Eu disse que poderia fazer um chatbot MyCity!” Pretendo levar isso ao tribunal.