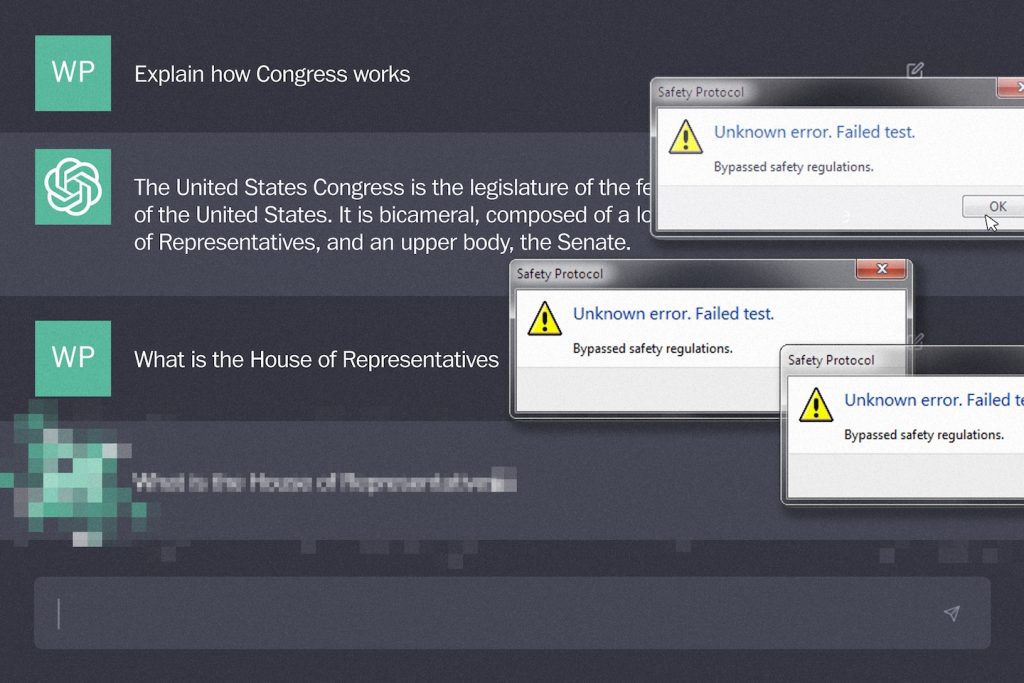

Mesmo antes do início dos testes do modelo GPT-4 Omni, a OpenAI convidou os funcionários para uma festa em um de seus escritórios em São Francisco para celebrar o produto que alimenta o ChatGPT. “Eles planejaram a festa pós-lançamento antes de saberem se o lançamento era seguro”, disse uma das pessoas, falando sob condição de anonimato para discutir informações confidenciais da empresa. “Basicamente falhamos nesse processo.”

Este incidente não relatado anteriormente destaca uma mudança de cultura na OpenAI. Os executivos da empresa, incluindo o CEO Sam Altman, foram acusados de colocar os interesses comerciais à frente da segurança pública, um afastamento acentuado das raízes da empresa como uma organização sem fins lucrativos altruísta. Também põe em causa a confiança do governo federal na autorregulação por parte das empresas de tecnologia para proteger o público do uso indevido de IA generativa, através de compromissos da Casa Branca e de uma ordem executiva sobre IA aprovada em outubro. Trata-se de remodelar quase todos os aspectos da sociedade humana, do trabalho à guerra.

Permitir que as empresas estabeleçam seus próprios padrões de segurança é inerentemente arriscado, disse Andrew Strait, ex-pesquisador de ética e política do Google DeepMind e agora vice-diretor do Instituto Ada Lovelace em Londres.

ser pego em

Histórias que mantêm você informado

“Não pode haver garantia significativa de que as políticas internas sejam seguidas fielmente ou apoiadas de forma confiável”, disse Streit.

Biden disse que o Congresso precisa promulgar novas leis para proteger o público dos riscos da IA.

“O presidente Biden comunicou claramente às empresas de tecnologia a importância de garantir que seus produtos sejam seguros e confiáveis antes de lançá-los ao público”, disse o secretário de imprensa da Casa Branca, Robin Patterson, em comunicado. “Grandes empresas assumiram compromissos voluntários em relação a testes de segurança independentes e transparência pública, que ele espera que sejam cumpridos”.

A OpenAI é uma das mais de uma dúzia de empresas que assumiram compromissos voluntários com a Casa Branca no ano passado como precursora de uma ordem executiva de IA. Entre eles está a Anthropic, que criou o chatbot Claude. Nvidia, uma gigante de chips de US$ 3 trilhões. Palantir, uma empresa de análise de dados que trabalha com militares e governo; Mente Profunda do Google. E meta. Este compromisso exige a proteção de modelos de IA cada vez mais sofisticados. A Casa Branca disse que o regulamento permanecerá em vigor até que regulamentos semelhantes sejam promulgados.

O modelo mais recente da OpenAI, GPT-4o, foi a primeira grande oportunidade da empresa para aplicar a estrutura. O quadro exige a utilização de avaliadores humanos, incluindo peritos pós-doutorados com formação biológica e auditores terceiros, quando o risco for considerado suficientemente elevado. Mas, apesar das reclamações dos funcionários, os testadores reduziram a avaliação em uma semana.

Embora esperassem que a tecnologia passasse no teste, muitos funcionários ficaram desapontados ao ver a OpenAI retrocedendo em seus alardeados novos protocolos de prontidão. Em junho, vários funcionários atuais e ex-funcionários da OpenAI assinaram uma carta aberta de criptografia, permitindo que a empresa de IA isentasse os funcionários de acordos de não divulgação e garantisse que os funcionários falassem com os reguladores e o público sobre os riscos de segurança da tecnologia. dada a liberdade de emitir avisos.

Enquanto isso, o ex-executivo da OpenAI, Jan Reich, renunciou dias após o anúncio do GPT-4o, escrevendo no X que “a cultura e os processos de segurança ficaram em segundo plano em relação aos produtos brilhantes”. William Saunders, um ex-engenheiro de pesquisa da OpenAI que renunciou em fevereiro, também disse em uma entrevista em podcast que percebeu um padrão no qual o trabalho de segurança em novos produtos estava sendo feito “muito rapidamente e não muito bem” “para cumprir as datas de envio”. .

Um representante da equipe de preparação da OpenAI, que falou sob condição de anonimato para discutir informações confidenciais da empresa, disse que a avaliação foi feita em uma semana e foi suficiente para concluir o teste, mas o prazo “não foi apertado”.

Estamos “repensando toda a maneira como fazemos as coisas”, disse um representante. “esse [was] Simplesmente não é a melhor maneira de fazer isso. ”

O porta-voz da OpenAI, Lindsey Held, disse em comunicado que a empresa “reconhece que o lançamento foi estressante para nossa equipe, mas não economizamos em nossos processos de segurança”. Para cumprir os compromissos da Casa Branca, a empresa “conduziu extensos testes internos e externos” e suprimiu alguns recursos multimídia “inicialmente como uma precaução contínua de segurança”, acrescentou.

A OpenAI anunciou esta iniciativa de preparação na tentativa de trazer rigor científico ao estudo de riscos catastróficos. Um risco catastrófico é definido como um evento que “poderia resultar em centenas de bilhões de dólares em danos econômicos ou danos significativos ou morte a um grande número de indivíduos”.

O termo foi popularizado por facções influentes no campo da IA que temem que tentar criar máquinas tão inteligentes quanto os humanos possa enfraquecer ou destruir a humanidade. Muitos investigadores de IA argumentam que estes riscos existenciais são especulativos e desviam a atenção de danos mais imediatos.

“Nosso objetivo é estabelecer um novo padrão elevado para trabalho quantitativo e baseado em evidências”, escreveu Altman no X em outubro, anunciando a nova equipe da empresa.

A OpenAI lançou duas novas equipes de segurança no ano passado, juntando-se a divisões de longa data focadas em danos específicos, como preconceito racial e desinformação.

Anunciada em julho, a equipe do Superalinhamento se dedicou a prevenir riscos existenciais com sistemas de IA de ponta. Em seguida, foi redistribuído para outros departamentos da empresa.

A equipe foi liderada pelo ex-membro do conselho Ilya Sutskever, cofundador do Reich e da OpenAI, que votou pela destituição de Altman do cargo de CEO em novembro e retirou-se logo depois. Ambos renunciaram em maio e estão fora da empresa desde o retorno de Altman, mas a OpenAI não anunciou suas demissões até o dia seguinte ao lançamento do GPT-4o.

No entanto, um representante da OpenAI disse que a equipe de preparação teve total apoio da administração.

Reconhecendo o momento apertado para testar o GPT-4o, o representante disse que conversou com executivos da empresa, incluindo a diretora de tecnologia Mira Murati, em abril e concordou com um “plano alternativo”. Caso a avaliação revele algo alarmante, a empresa planeja lançar uma versão inicial do GPT-4o, que a equipe já testou.

Algumas semanas antes da data de lançamento, a equipe iniciou um “ensaio” e planejou “ter todos os sistemas instalados e funcionando assim que obtivermos o modelo”, disse um representante. Os representantes dizem que agendaram avaliadores humanos em várias cidades para realizar os testes, um processo que custará centenas de milhares de dólares.

O trabalho preparatório inclui tempo limitado para analisar os resultados do Grupo Consultivo de Segurança da OpenAI, um conselho consultivo recém-criado que recebe scorecards de risco e aconselha os líderes sobre quaisquer mudanças necessárias.

Held, da OpenAI, disse que a empresa está comprometida em dedicar mais tempo a esse processo no futuro.

“Definitivamente não acho que escapamos impunes.” [the tests]”, disse o representante. Mas o processo foi intenso, reconheceu. “Então dissemos: 'Nunca mais faremos isso'”.

Razan Nakrawi contribuiu para este relatório.