Antes do Google I/O 2024, havia poucas dúvidas de que o Google estaria falando sobre IA. O evento começou com uma atmosfera adequadamente estridente. A sensação do YouTube, Marc Rebillet, emergiu de uma xícara gigante e começou o show vestindo um roupão de banho.

A estrela da mídia social deu o tom para o resto do evento, pedindo ao público ideias musicais selvagens, trazidas à vida pelo software AI DJ do Google. Os anfitriões não poderiam ter começado melhor. De acordo com o CEO Sundar Pichai, os executivos do Google disseram a palavra “IA” 121 vezes.

No final do evento, fiquei com duas perguntas que ficaram na minha cabeça. Um: o Google está tentando resolver problemas que nem existem na vida das pessoas normais, forçando-as a comer o sorvete Gemini? Dois: a IA do seu telefone tem superpoderes incríveis. Existe um mercado para hardware especializado de IA que vale centenas de dólares?

Status atual dos acessórios AI

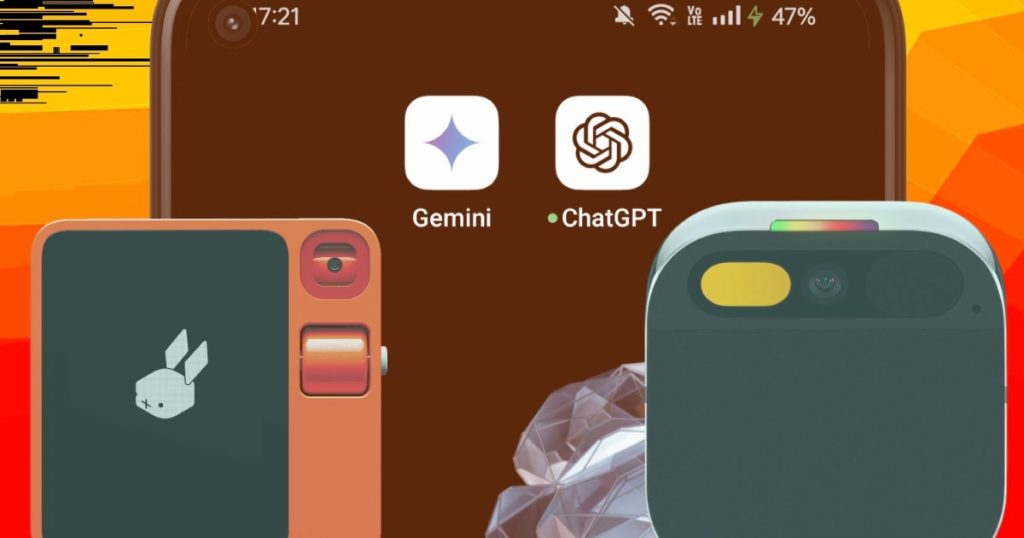

Até agora, temos alguns gadgets de IA laranja fofos, como o Rabbit R1, e alguns ótimos, como o Humane AI Pin. Uma marca também fabrica pingentes de IA. Algumas pessoas apenas ouvem. Alguns falam com você, gravam vídeos, fazem ligações, usam bots de IA conversadores e até tentam entender o mundo ao seu redor.

Agora, não vou discutir o quão mal esses dispositivos funcionaram até agora. Mas o editor da seção móvel da Digital Trends, Joe Marling, diz que o Rabbit R1 é um dos piores gadgets que ele já usou. A história do Humane AI Pin não é tão diferente. ah! Agora, todos esses são dispositivos de primeira geração desse tipo, então vamos dar uma folga a eles.

Mas esta é a realidade. O futuro deles não parece brilhante, econômico ou conveniente. Em dois dias, dois pesos pesados da IA, OpenAI e Google, afirmaram isso definitivamente.

A IA agora conhece o mundo

Vamos começar com a visão, o poder que permite à IA ver o mundo através das lentes de uma câmera e falar sobre o que vê. O Google apresentou algo chamado Gemini Live no I/O 2024. No dia anterior, a OpenAI anunciou o GPT-4o. Aqui, “o” significa omnimodal. Esta é uma maneira elegante de dizer multimodal, o que significa que seus companheiros de IA podem processar texto, áudio e imagens como entrada e saída. No entanto, o objetivo final é o mesmo para ambos os produtos.

Ative a IA de sua escolha, aponte a câmera para praticamente qualquer coisa e ela responderá a perguntas contextuais. Você pode ativar a câmera frontal e fazer com que a IA explique como você está jogando pedra, papel e tesoura com seus amigos. Você saberá se sua camisa rosa não é a melhor roupa para uma entrevista de emprego.

Se quiser, você pode ver objetos e descrevê-los em português, identificar prédios como seu guia turístico de confiança e sentir que é uma ocasião especial ao ver confetes espalhados sobre uma mesa. Ao segurá-lo sobre o código, a IA explicará o propósito do código. E se a IA vir as chaves do seu carro em qualquer lugar, ela lhe dirá exatamente onde você as deixou.

Demonstração ao vivo dos recursos de visão do GPT-4o

Agora, todos os recursos mencionados acima não são uniformes no ChatGPT (que usa muito suco GPT-4o) e no Gemini Live (que tem a tecnologia Google Astra por trás dele). No entanto, os fundamentos são compartilhados. Este também é um momento crítico em que a linha de falha se amplia entre a experiência de IA em telefones celulares e a experiência de IA em hardware dedicado.

Desafios de hardware

Rabbit R1 e Humane AI Pin estão equipados com câmeras de 8 megapixels e 12 MP, respectivamente. Claro, eles podem ver o mundo e entendê-lo, mas não conseguem igualar os recursos visuais das câmeras de alta resolução estabilizadas opticamente nos smartphones da geração atual.

Em suma, o smartphone médio alimenta pontos de dados visuais mais saudáveis para um motor de IA local ou baseado na nuvem, o que se traduz diretamente numa melhor compreensão. Pense nisso como comparar um videoblog econômico a um telefone principal e fazer com que eles expliquem tudo o que veem. É claro que clipes borrados ou estourados não ajudarão muito aqui.

A seguir vem a parte de computação. Entre eles, os gadgets de IA mais interessantes em 2024 funcionarão com silício MediaTek e Qualcomm de nível baixo a médio. Esses dispositivos não são sobrecarregados pelo peso de um sistema operacional geral, mas pelo que vimos até agora, mesmo smartphones intermediários podem lidar com tarefas de IA em um ritmo dramaticamente mais rápido do que o R1 ou o Pin do Humane.

Você não quer que seu gadget de IA leve 15 segundos para processar uma solicitação quando o bom e velho Siri pode fazer um trabalho melhor. Esse é um benchmark ruim, mas é aí que está o R1. Agora que estamos falando de silício, vamos explicar como o processamento desempenha um papel fundamental aqui. Os truques de IA generativa são realizados de duas maneiras. A maioria das soluções envia consultas para servidores em nuvem. Isso significa que você precisa de uma conexão com a Internet.

A segunda opção é o processamento offline, que é o que o modelo Gemini Nano do Google faz em dispositivos como a série Pixel 8 e telefones Samsung. A maior vantagem é que este cenário não requer conexão com a internet. Atualmente, não existe AI Thingamajig que funcione sem uma conexão com a Internet.

A IA no dispositivo é uma verdadeira joia

O processamento no dispositivo permite que o aplicativo Gravador do seu smartphone Pixel transcreva e resuma gravações de áudio. Magic Compose leva seu jogo de mensagens de texto para o próximo nível, sem a necessidade de conectividade Wi-Fi ou celular. O mesmo vale para tradução e transcrição. Na verdade, o Google lançou as bases para uma tradução off-line confiável em 2018, usando tecnologia de tradução automática neural.

Mas isso é apenas a ponta do iceberg. Ainda este ano, o Google planeja lançar o Gemini Nano com multimodalidade. Isso significa que você não precisa de uma conexão com a Internet para que o Gemini Live veja e entenda o que você vê e ouve através da câmera, tela e microfone do seu telefone e forneça respostas contextuais.

O Google está aprimorando os recursos de acessibilidade do TalkBack com o Gemini. Esta é uma grande vitória para pessoas que têm problemas de áudio e visibilidade e precisam de um companheiro TalkBack confiável com recursos multimodais, mas não têm acesso a uma conexão com a Internet.

Mencionamos também que o processamento de IA no dispositivo é mais rápido e dramaticamente mais seguro, pois nenhum dado é vazado do seu telefone. Mais importante ainda, ele reduz o custo de fornecimento de recursos de IA generativos.

O custo para os consumidores é atualmente uma das maiores incertezas em toda a estratégia de marketing de telefonia de IA. A IA no dispositivo é um grande suspiro de alívio em meio a esse caos, pois pelo menos tenho uma ideia da funcionalidade mínima que meu telefone pode executar sem ter que me preocupar muito com a compatibilidade de recursos nos próximos anos. vou colocá-lo.

Gêmeos está fazendo certo

Finalmente, há a importante questão da interação. Minha vida gira em torno do Gmail, Docs, Drive, Maps, Photos, Search, etc. O Google criou Gems, também conhecidos como assistentes personalizados baseados em Gemini, para lidar com tarefas específicas que funcionam em estreita colaboração com outros produtos do ecossistema.

Por exemplo, quando você pede ao Gemini para planejar sua viagem, ele olha sua caixa de entrada do Gmail, agenda passagens e combina dados de prompt de voz/texto com informações relevantes de pesquisa do Google para criar um itinerário completo.

Aqueles dispostos a pagar pelo Gemini aAdvanced obtêm ainda mais superpoderes de produtividade. Ele pode processar até 1.500 páginas de PDF, 30.000 linhas de código, 1 hora de vídeo ou uma combinação de diferentes formatos de arquivo.

Gêmeos processa todas essas informações, fornece uma versão condensada, identifica aspectos importantes e também atua como professor depois que todo o material é ingerido. Você pode até usar uma planilha comum para criar relatórios financeiros detalhados com uma compreensão clara dos lucros e insights relacionados.

A IA também escuta chamadas e alerta os usuários se quem liga é uma fraude. Na verdade, o Gemini nem mesmo leva você para outro aplicativo. Quando você precisar, a interface do Gemini simplesmente passa o mouse sobre o aplicativo que você está usando no momento, executa sua função e desaparece.

É difícil vencer os smartphones

O que quero dizer aqui é que a IA deve atuar como um assistente, mas precisamos encontrar o equilíbrio certo entre diversidade de funcionalidades e conveniência prática. Só posso fazer isso se tiver acesso a dados que são importantes para mim, pessoal e profissionalmente. E queremos que todos esses recursos inteligentes sejam fornecidos da melhor maneira possível, sem qualquer sobrecarga financeira adicional.

No momento, coisas como Rabbit R1 e Humane AI Pin mal arranham a superfície dessas interconexões profundas de produtos. Além disso, o próprio hardware impede que a IA atinja todo o seu potencial. Não consigo imaginar o Google licenciando o Gemini Nano para um produto como o Rabbit R1 e, mesmo que o fizesse, a experiência seria prejudicada pelo hardware.

Então, por que pagar mais e se contentar com uma experiência abaixo da média quando o telefone no seu bolso pode fazer um ótimo trabalho para você? E está aqui desde sempre. Enquanto isso, bugigangas de IA laranja brilhante estão praticamente mortas.

Escolhas dos editores